Docker公司(5月10日)宣布他们推出了新的安全扫描技术,此技术用于在整个软件供应链中保障容器内容。

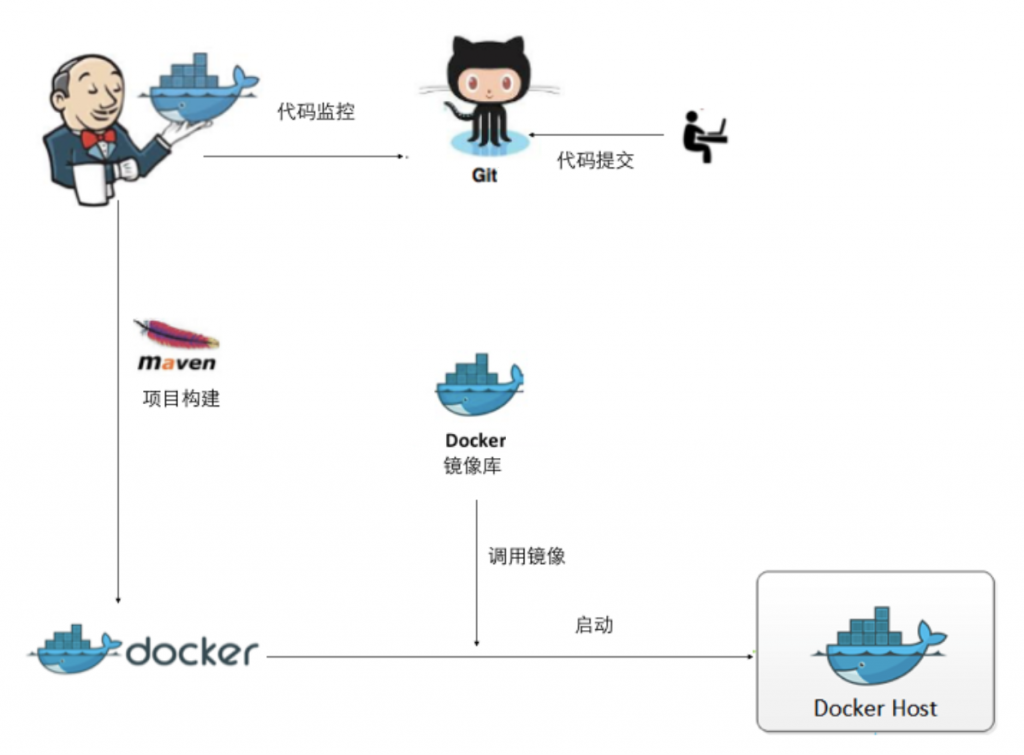

Docker安全扫描是Docker云私有仓库计划的一个可选服务。它提供对容器镜像内的软件安全性评估。

这项服务提供的细节使得IT运营人员可以评估软件是否符合安全合规标准。 与现有的开发工作和IT工作流程无缝集成,每当有变更分发时就会触发扫描,在部署前增加一个检查点,该公司表示。

Docker的安全主管Nathan McCauley说:“扫描过程会创建一个类似汤罐内容标签的镜像签名。”

Docker公司说,Docker安全扫描可以涵盖任何应用程序和所有主流Linux发行版。 它提供了集成到容器即服务的工作流,通过集中IT管理的安全内容提升企业的安全态势。

作为安全增强的一部分,该公司还发布了Docker Bench的一个更新。该版本自动按照CIS基准建议验证主机的配置。通过更新,Docker用户可以采用最新的CIS Docker基准建议,以确保他们的平台配置与Docker引擎1.11版本的最佳实践是一致的,McCauley告诉LinuxInsider说。

此安全流程回答了有关计算机安全的几个关键问题。 它告诉用户Docker容器的内容。 它可以让用户知道代码来源,如何避免坏的部分以及如何基于合规和管理保持当前补丁到最新。

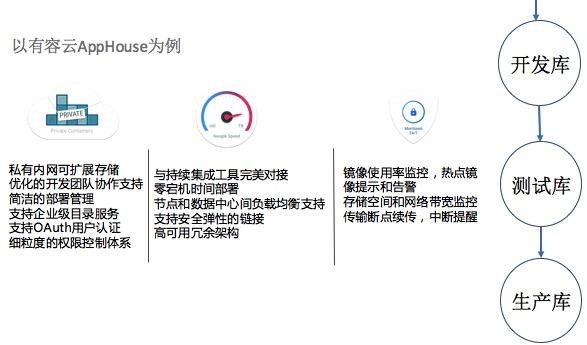

McCauley说“伴随着这个过程,开发人员成为安全过程的一部分。开发人员在他们部署软件之前就可以看到扫描过程的结果”。“我们做它的目的就是保护从开发,测试到生产的整个软件供应链。”

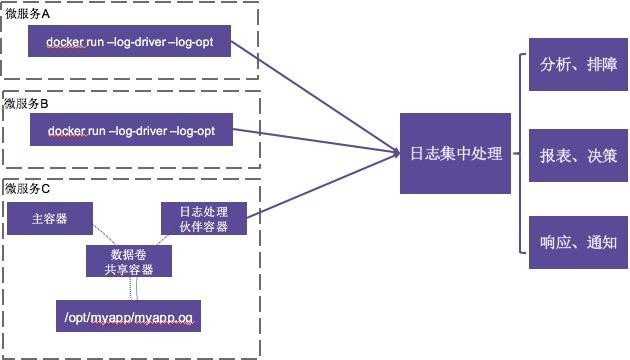

Docker镜像扫描和漏洞检测提供颗粒层次审计镜像的容器优化的能力。根据扫描的结果,会对每个镜像提供一份包含镜像层和组成的细节清单,并且附带每个组成的安全描述。

这使得独立软件供应商、发布商和应用团队可以根据他们的安全策略进行正确的决策。 ISVs可以利用这些信息来积极修复漏洞,以保证其内容的高品质安全级别,并透明地部署到他们的最终用户。应用程序团队基于所显示的配置文件,可以决定是否要使用ISV提供的镜像并在决定部署前可以灵活的使用安全扫描检查额外的代码。

如果没有可选的增强安全性,IT从业者要依赖于各ISV对其提供内容的常见漏洞状态发布信息,披露的数据库并且手动跟踪他们的任何问题。 Docker安全扫描将自动化这个过程,当镜像中的任何内容报告发现漏洞时都会自动通知企业。

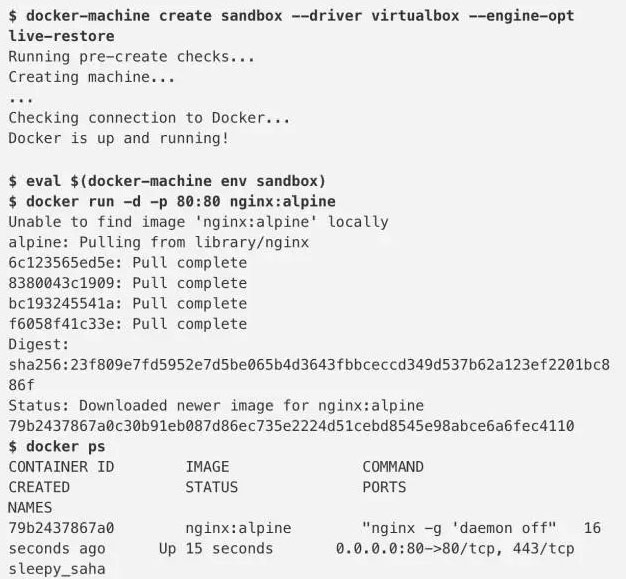

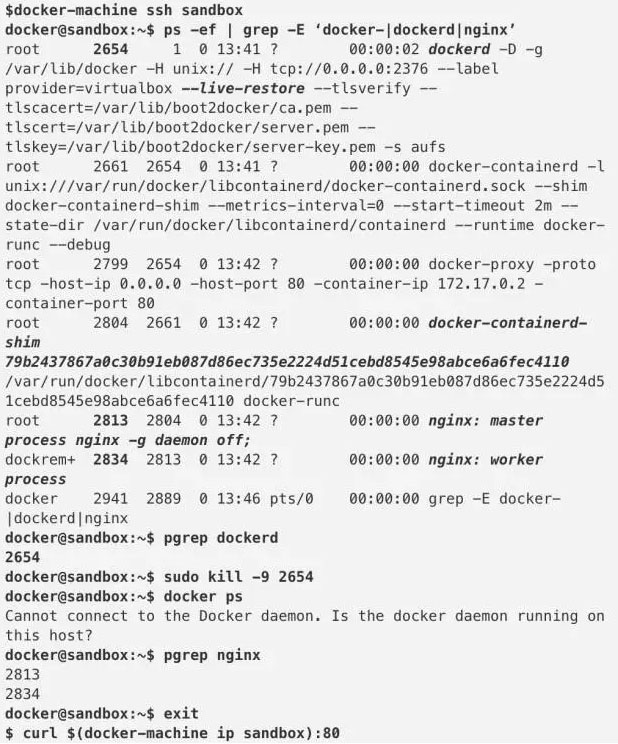

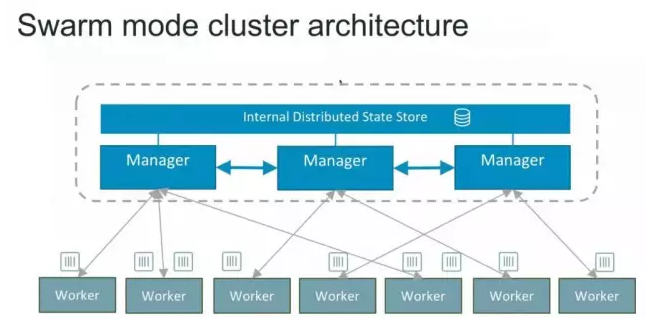

Rackspace公司的架构师Adrian Otto说,即将推出的Docker Engine将使用multidaemon方法分离特权,使得它比以前版本中使的single-daemon设计更加安全。这也是Docker如何持续改善安全态势的一个例子。

他还告诉LinuxInside:“我们相信类似的增强会继续下去,因为开发是由用户和开发人员组成的社区推动的,由于威胁和复杂的竞争对手日趋活跃,他们越来越关注应用安全”。

不管是否使用容器技术,安全性都是所有支持云的应用程序需要关注的。对漏洞进行持续扫描肯定是安全的最佳实践。理想情况下,安全扫描应该包含在容器宿主机系统中,以保持应用程序的安全,奥托说。

Sungard Availability Services公司的首席安全体系技术官Scott Moore 说,对于安全问题,虽然Docker的技术还有很大的成长空间,但是现在正在大步朝前。

Docker Engine 1.10版本重点几乎全是安全。1.11版本是第一个内置runC以及Containerd 并且符合开放目录接口标准的版本。

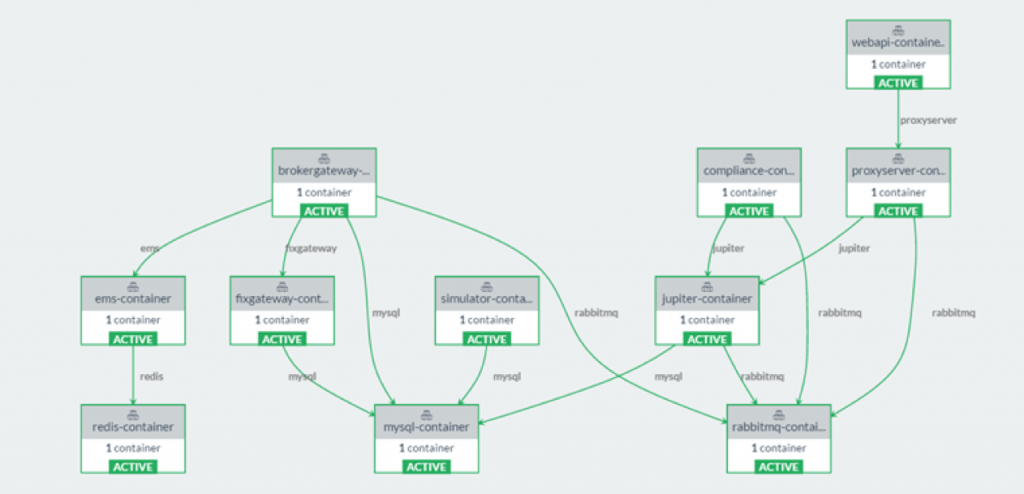

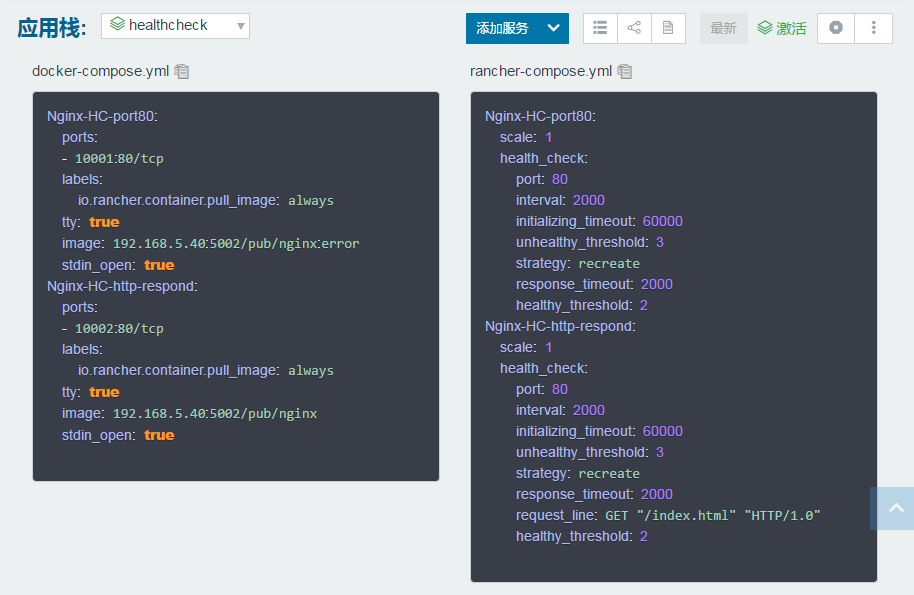

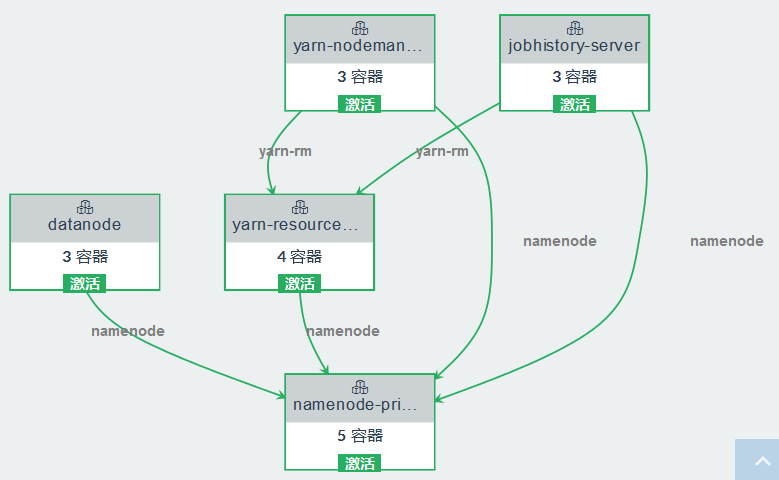

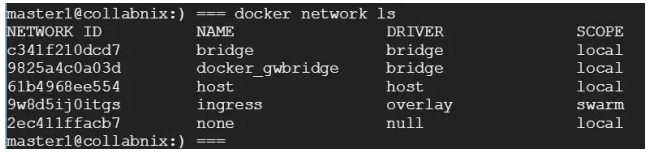

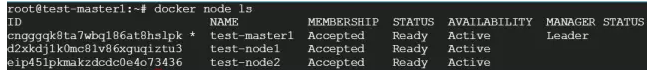

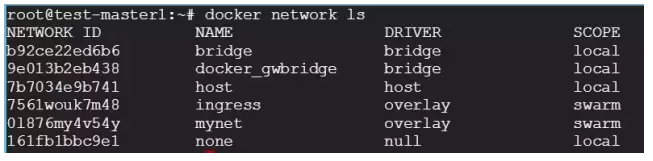

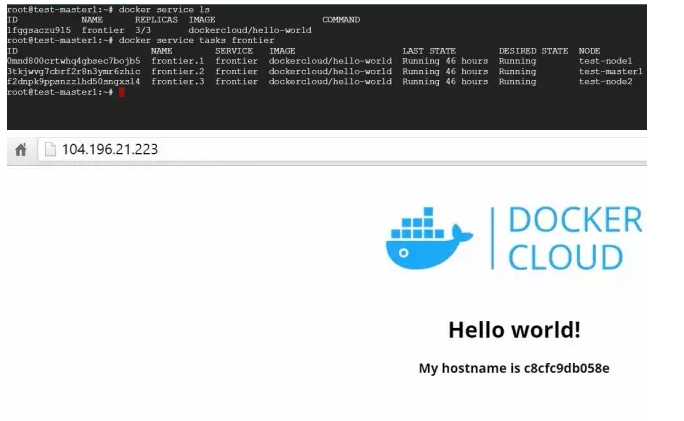

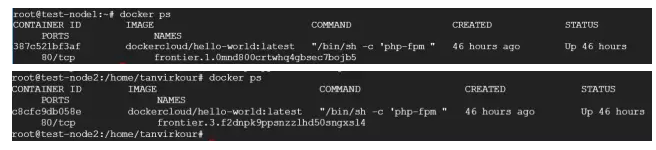

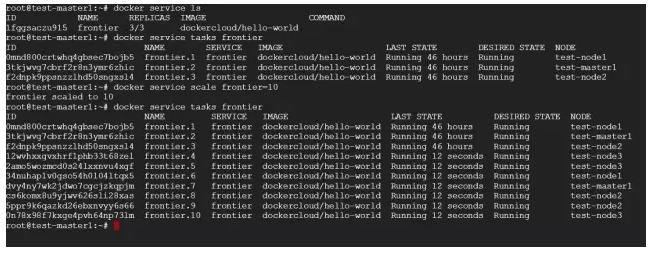

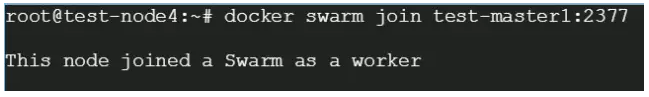

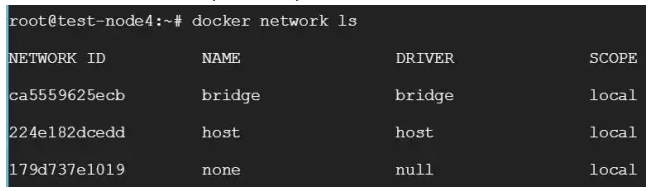

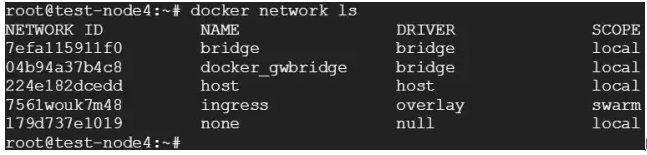

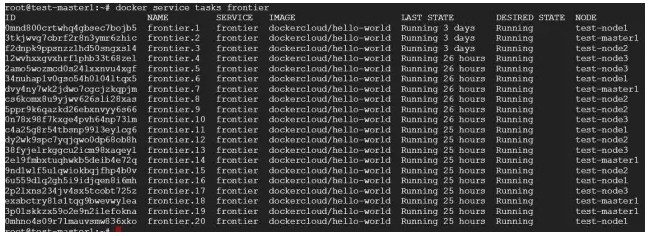

Docker云是一个容器即服务的解决方案,允许客户可以从任何云供应商加入自己的节点。客户创建和运行节点,所以Docker不负责主机的安全性。Docker云会从节点提取信息,并将其存放在Docker云中,并且它对于从节点收集的元数据没有认证机制。

Scott Moore还说,“如果用于授权的Docker ID泄露,有人能够获得Docker云管理的任何节点的容器访问。此时,Docker Cloud没有细致的,基于权限的访问控制或者API密钥管理”。

Kilmon说:Docker Cloud是在云中运行容器的解决方案。即使Docker Cloud 是安全的,但这并不意味着你在之上为你的云解决方案运行的容器是安全的。

Kilmon说,Docker Cloud只是作为其组成部分是安全的。云安全在很大程度上取决于如何使用它。

例如,如果你提供一个Amazon Web Services实例或一个节点来运行容器,并且这是不安全的,那么这将是整个链条中的一个薄弱环节。

Kilmon说,“Docker Cloud无非是托管Docker基础设施的,像Docker registry,Docker engine等等,托管的基础设施是安全的,但你在基础设施上运行的Docker容器仍然可能是不安全的”。

Docker安全扫描可用于Docker Cloud用户的私有仓库计划。在第三季度末,范围将扩大到所有的Docker Cloud仓库用户。

最初的免费试用期结束后,作为私有仓库计划的一个附加服务,定价为2$每仓库。在2016年下半年,Docker安全扫描也将做为Docker数据中心集成的功能可用。

CloudPassage的首席技术专家 Sami Laine指出,增强安全性的附加工具是一个巨大需求。大多数企业在管理复杂的环境,包括传统的裸金属服务器,虚拟化,私有云和公共云上运行的工作负载,以及可能部署在所有这些环境的容器。

他还告诉LinuxInsider,“拥有综合性工具能够对IT交付的场景提供可视化和合规控制, 包括检查容器引擎和镜像的能力,这只会变得更加重要,而不是无关紧要。”

据Bromium的CTO Simon Crosby说 ,一个问题Docker容器可以攻击它的宿主机或其他容器。Docker之间的隔离是好的,但它并没虚拟机那么好,在CPU级别强制隔离。

他还对LinuxInsider说,“基本上,Docker已经远远超过传统漏洞百出的企业级服务应用和基础设施”。

DockerInfo

DockerInfo